🚗

“小X,帮我关闭主驾车窗、空调开到22度、打开座椅通风,然后开始播放我最爱听的播客”;

“小X,我要睡20分钟,时间到了叫醒我”;

“小X,旁边的河是什么河”;

“小X,打开这个(手指天窗)”;

……

仿佛一夜之间,车载语音助手就成了“AI智能助手”——不仅可以自然流畅地连续对话、执行多任务,而且还能耐心地答疑解惑,指一指就完成任务,以及善解人意地陪你聊天。

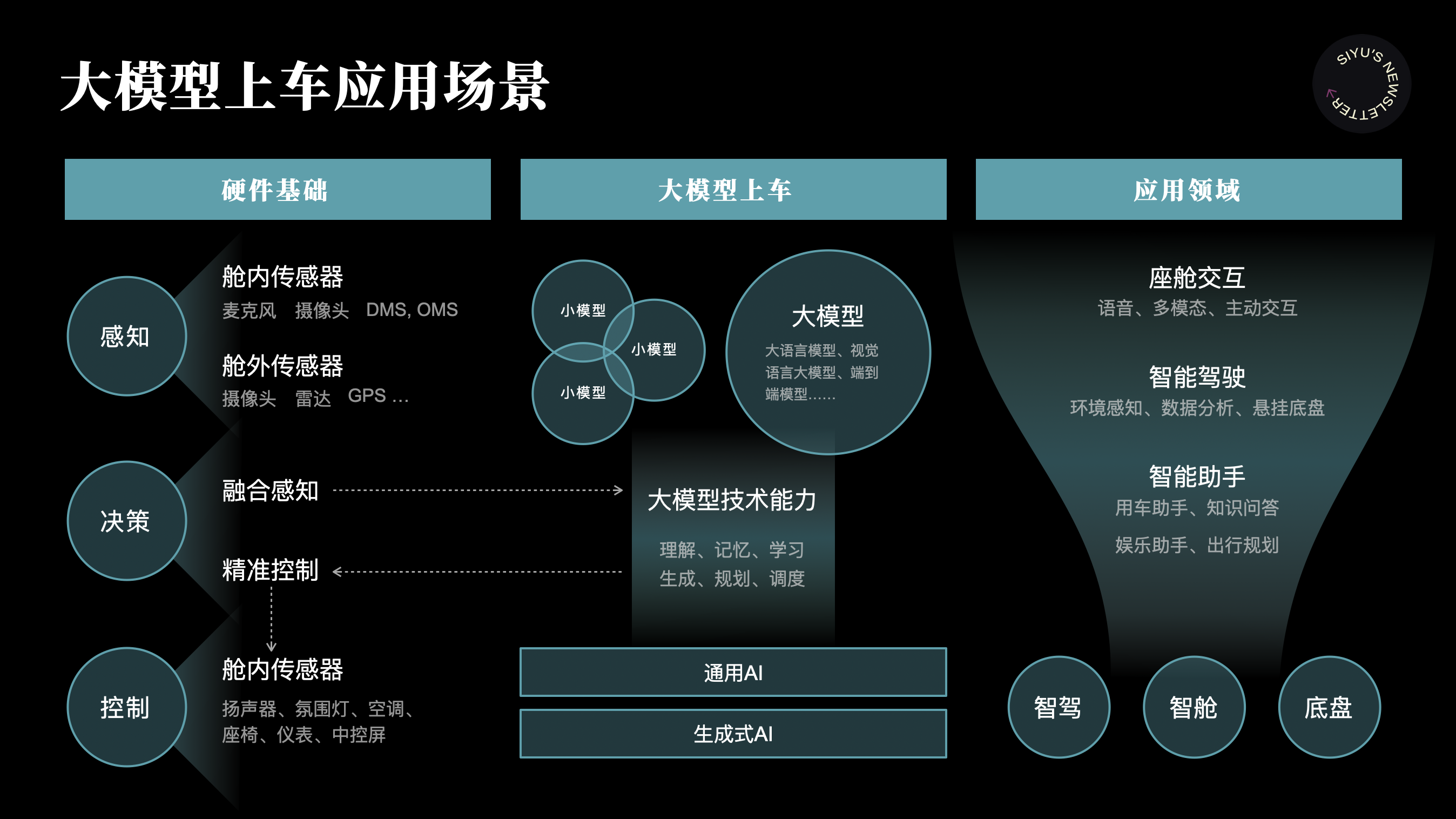

这主要得益于人工智能大模型的发展。过去一年多,AI大模型加速“上车”,融入到智能驾驶、智能座舱、数字底盘等整车设计中,当中以AI智能助手的应用最为显性化。

大模型上车应用场景

假如有一天(应该不会太久),AI智能助手成为智能座舱的核心,甚至有人说,未来的座舱是“AI智能座舱”,那汽车人机交互会朝着什么方向演变?今天的HMI设计还适用吗?

1. 车载AI智能助手现状

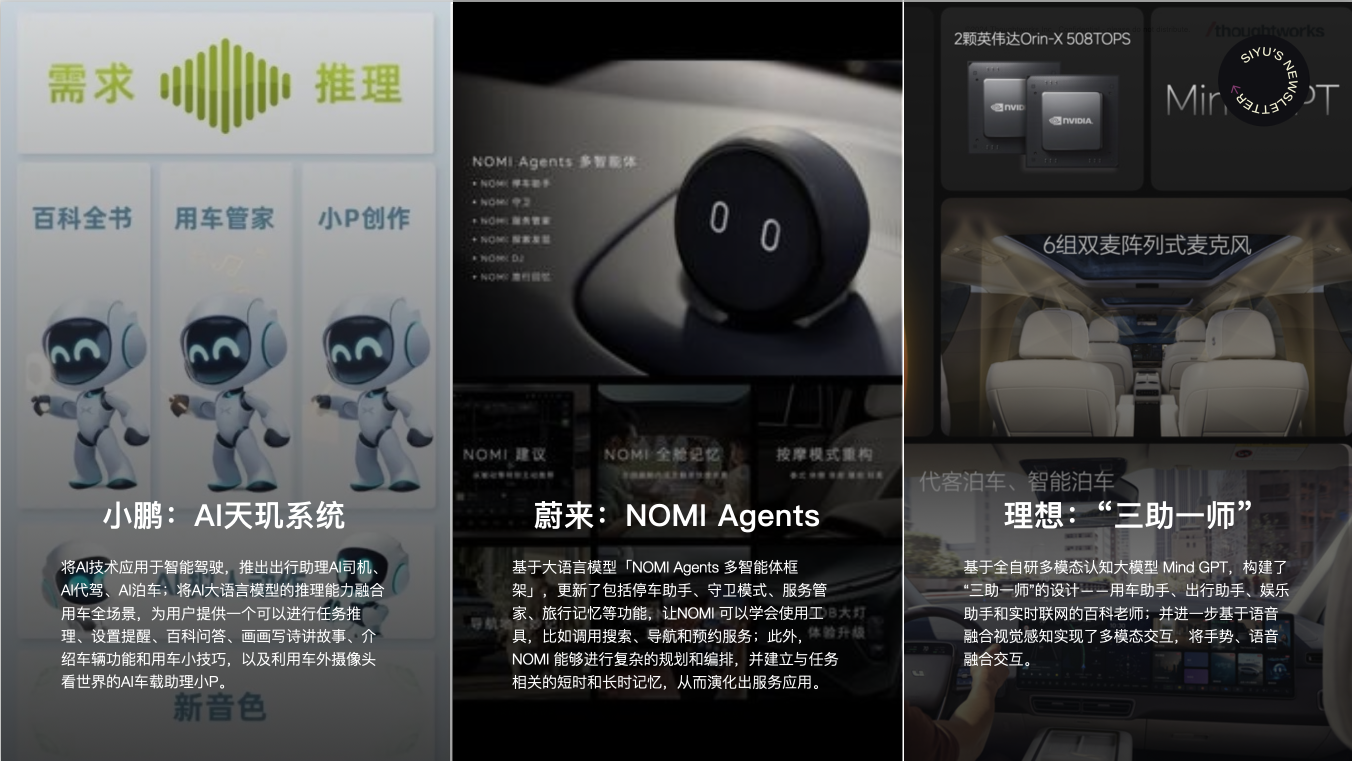

进入2024年,多家新能源车企推出搭载大模型的新车。理想、蔚来、小鹏、华为、极越和小米等品牌,纷纷借助生成式 AI 和大模型升级车载语音助手:

理想的“理想同学”:基于自研的多模态认知大模型 Mind GPT,打造了“三助一师”——用车助手、出行助手、娱乐助手和实时联网的百科老师;并进一步基于语音融合视觉感知实现了多模态交互,比如乘客手指天窗说“打开这个”,理想同学可以识别语音和手势将天窗打开。

小鹏的“小P”:将AI大语言模型的推理能力融合用车全场景,为用户提供一个可以进行任务推理、提醒设置、百科问答、画画写诗讲故事、介绍车辆功能和用车小技巧,以及利用车外摄像头“看世界”的AI车载助理小P。比如说“我有点闷”,它就会帮你打开车窗;比如可以问它“前面是什么车”;以及让它“15分钟后提醒我回电话”。

蔚来的“NOMI”:基于大语言模型「NOMI Agents 多智能体框架」,更新了包括停车助手、守卫模式、服务管家、旅行记忆等功能,让NOMI可以学会使用工具,比如调用搜索、导航和预约服务;此外,NOMI 能够进行复杂的规划和编排,并建立与任务相关的短时和长时记忆,从而演化出更多服务应用,比如根据用户习惯和情境,NOMI可以主动提供座椅调整建议。

华为的“小艺”:一个与华为生态系统紧密连接的语音助手,提供全面的车载与跨设备体验。小艺支持拖拽交互方式,覆盖车机全局,可以将文字、图片、文档等内容拖拽给小艺。比如拖拽一段开会通知文本后,它能迅速展开日历创建日程。

极越的“SIMO”:融合百度文心一言大模型能力,SIMO 2.0支持沿途地点查询、智能推荐出行地点,可提供产品参数、功能故障诊断;同时支持超一万个场景创建、全车可调用文心一言、粤语识别、唇动识别(适用于嘈杂环境)等功能。

2024年新能源车企纷纷推出搭载大模型的智能助手

AI赋予车载语音助手感知、理解、学习、决策和执行能力,大模型则让这些能力实现质的飞跃,尤其在逻辑推理、多模态输入及生成,以及复杂任务处理方面。AI智能助手能更好地理解用户偏好、预判需求,并提供更个性化的响应。

2. 智能座舱交互环境特点

在分析AI智能助手如何重塑座舱交互前,先看看座舱交互有什么特点:

1) 语音比触控更适合座舱

在汽车座舱三维空间中,语音交互相较于触控操作更为高效和安全。尤其是在驾驶时,通过语音和车交互可以避免分散注意力,减少因操作触摸屏而带来的安全隐患;此外,与手机、平板不同(这些设备可携带,触屏交互很方便),车机的触屏操作需要人靠近和转换姿势;还有就是,语音交互可以同时下达多个指令,用户只需动动口,就能完成可能需要点击几次、十几次的操作。尽管目前车内交互以触屏为主、语音为辅,但从人因角度来说,其实应该调转。

2) 本应多模态实际视觉过载

在物理世界中,人类通过视觉接收的信息占所有感官通道接收信息的80%以上,听觉接收的信息占11%,触觉加嗅觉接收的信息差不多有5%。目前,在座舱里,驾驶员主要从仪表盘、中控、后视镜、HUD以及车外环境获取信息,大量占用视觉通道,而听觉、触觉通道等并没有被充分调用。触屏、语音、物理按键、手势、面部识别……多模态交互是智能座舱交互的特点,也是挑战所在——设计师需要发挥想象力和创造力,调用各种感官通道。

3) 非驾驶相关空间利用增多

自动驾驶持续发展,让汽车在出行工具之外,拓展出越来越多场景。设想一下,当 L4 自动驾驶技术实现后,汽车座舱将成为名副其实的“移动空间”,驾驶者和乘客的注意力和精力可以被大为释放。在这种情况下,智能座舱势必更加注重用户的休息、娱乐和办公需求。听起来是不是像我们在飞机、火车等有司机的交通工具上会做的事情?自动驾驶就是那个“代驾司机”。同时,汽车具有私密属性,所以大家又把车和家类比,车企也在把发生在家中的场景迁移到车上。

AI智能助手对座舱交互的影响

3. AI智能助手对座舱交互的影响

芯片、大模型技术仍在发展,AI智能助手的响应速度和智能水平还会提升。与此同时,智能座舱的人机交互与用户体验正在被重新定义:

1) 打破功能与应用边界

设计师花费大量时间梳理HMI信息架构和页面层级,主要为了减少操作步骤、提高车机易用性。但未来这件事可能变得不那么重要。因为车机、智能座舱的大量功能和服务,有了 AI 智能助手这个统一入口和出口,它可以打破隔离、跨越边界,快速定位用户需要的信息和功能。

🌰例如,当用户说 “我想听歌” 时,AI 智能助手可以自动搜索并播放用户喜欢的音乐,无需用户打开音乐应用、再打开收藏歌单;同时,AI 智能助手还可以根据用户的需求,搜寻其他相关的音乐服务,如音乐电台、音乐排行榜等,这些资源可能来自于音乐APP,也可能来自网络电台、好友分享,用户自己未必能想到或找到。

2) 结果动态生成而非千篇一律

以往,车载语音助手只会按照预设指令执行相应的操作。无论驾驶员还是乘客,无论大人还是小孩,获得的结果都一样。未来,AI智能助手会根据用户特征、用户提问和下命令的方式,动态生成结果和呈现界面,从而实现更灵活、千人千面的交互,而非调出一个编码预先写好的固定结果。

🌰例如,当用户说 “我有点热” 时,AI 智能助手可以识别是哪个位置的哪位乘客说出这句话,并根据他的历史数据、习惯偏好,自动执行操作,并给出相应反馈:“已将二排空调打开,温度是您常设的22度,是否合适?”它还可以根据当时的情形,推荐其他相关服务,如:“还可以为您打开座椅通风,是否需要?”这种生成式的交互方式更加个性化和情感化,可以有针对性地提供用户所需的功能和服务,打造专属座舱体验。

3) 更接近物理世界的交互

有车企把未来的汽车比作机器人,那人与车的交互,会不会越来越接近人与“人”的交互?也就是说,通过五感,包括视觉、听觉、触觉等去感知、理解和表达。这意味着,未来座舱交互设计会更多利用多模态进行输入输出,模拟人与人在物理世界的交互,并且会越来越自然可靠。

🌰例如,当用户说“当我犯困时提醒我一下”,AI智能助手可以凭借摄像头、方向盘等获取用户状态,结合外部环境、车辆行驶情况等,给出视觉、听觉、触觉等多种形式的“提醒”,避免让用户感到突兀或侵犯。再比如,当有人在车上抽烟,车主皱眉头时,AI智能助手可以感知车主情绪,替车主发声制止,并及时清洁车内空气。

illustration from freepik

随着 AI 助手成为智能座舱的核心,触控交互向语音和多模态转变,智能座舱需要采用新的交互框架,使其更具前瞻性和延展性。产品经理和设计师们应该:

持续关注和学习AI技术发展与应用:深入理解AI技术,特别是生成式AI和大模型技术,以便理解AI智能助手“可以”实现怎样的功能和应用;

始终从用户场景和需求出发:通过用户研究了解用户行为模式和出行场景,明确用户“需要”怎样的功能和服务,继而明确需要怎样的交互形式以及个性化服务所需的数据基础和判断条件;

以前瞻研究指引当下:在日新月异的新能源汽车和智能座舱领域,研究未来和提前布局至关重要,需要站在未来倒推现在,以前瞻POC项目引领量产项目,避免走错路走弯路,或是变革到来时毫无准备。

总的来说,AI智能助手将为智能座舱HMI交互带来革命性的变化。首先看AI大模型的能力可以去到哪里,然后再看它有什么样的交互方式。而最好的准备方式,就是积极了解学习,寻找落地场景,大胆尝试运用。

📚 参考:

数十家车企集体开“卷”AI智能座舱 https://new.qq.com/rain/a/20240803A06KV800

开启AI智驾时代总共分几步?小鹏520 AI DAY带你一探究竟 https://www.xiaopeng.com/news/company_news/5307.html

NOMI GPT 为什么能懂你? https://www.nio.cn/smart-technology/20240802004

小艺能力大提升,升级为系统级智能体! https://www.csdn.net/article/2024-06-21/139867907

极越汽车智驾座舱2.0 OTA升级内容公布:新增4大功能 https://auto.zol.com.cn/895/8958945.html